服装の個別アイテムの特徴に注目して曖昧なファッションの表現をAIが自動で解釈する技術を開発

発表のポイント

● ファッションの説明には「カジュアル」「フォーマル」「かわいい」といった曖昧な表現が用いられるため、一般のユーザーがファッションを理解・解釈することは容易ではありません。

● 本研究グループでは先行研究で、ファッションへのイメージを自動的に学習・解釈し、ユーザーからの曖昧な問いに対する回答を得る技術を開発していました。今回、新たな技術として服装の個別アイテム(Tシャツ、パンツ、スカート等)に関する質問に回答可能な機械学習モデル「Partial Visual-Semantic Embedding」を開発しました。

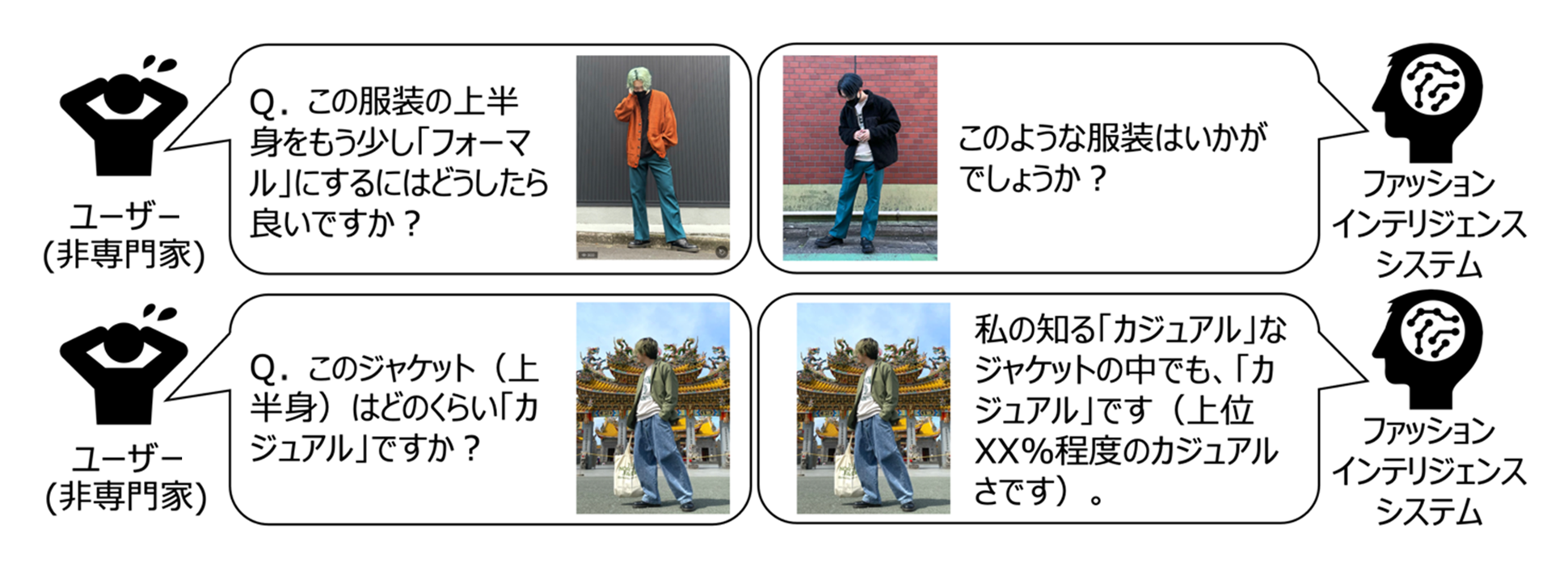

● 開発モデルにより「この服装の上半身はどのくらいカジュアルか」「この服装の上半身をもう少しビジネスカジュアルにしたい」といった、ファッションに関するより詳細な質問に回答できるようになります。この成果により、着る服や購入するアイテムなどファッションに関するユーザーのあらゆる選択・行動を支援することが期待されます。

早稲田大学(東京都新宿区、総長:田中愛治)大学院創造理工学研究科博士後期課程および株式会社ZOZO NEXT(本社:千葉県千葉市、代表取締役CEO:澤田宏太郎)の研究開発組織、ZOZO研究所に在籍する清水良太郎(しみずりょうたろう)、早稲田大学理工学術院 教授の後藤正幸(ごとうまさゆき)、およびZOZO研究所の中村拓磨(なかむらたくま)による研究グループは、ファッションへのイメージを自動的に学習・解釈し、ユーザーからの曖昧な問いに対する回答を得るための「Fashion Intelligence System」※1の精度を向上させた上で、新たな機能を実現するための機械学習モデルを開発しました。今回開発したモデルでは、「この服装の上半身(下半身、靴など)はどのくらいカジュアルか」「この服装の上半身をもう少しビジネスカジュアルにするとどのような服装になるか」などのユーザーからのより詳細な質問への回答を得ることができます。

本研究成果は、オランダのエルゼビア社が発行する『Knowledge-Based Systems』(論文名:Partial visual-semantic embedding: Fine-grained outfit image representation with massive volumes of tags via angular-based contrastive learning)にて2023年7月28日(現地時間)にVersion of Record(最終公開版)としてオンラインで掲載されました。

(1) これまでの研究で分かっていたこと(研究の背景)

ファッションを説明する際には通常「カジュアル」「フォーマル」「かわいい」といった曖昧な表現が用いられるため、専門家でないユーザーがファッションを理解・解釈することは容易ではありません。このようなファッション分野特有の曖昧性は、ユーザーがファッションへの苦手意識を持ったり、新しいジャンルの服装に挑戦することを困難にするなど、ユーザーがファッションへの興味を深めることの妨げとなる可能性があります。

この問題を解決するために、以前本研究グループでは「Fashion Intelligence System」という技術を開発しました。この技術により、例えば、1)「この服装をもう少しフォーマルにしたらどんな服装になるか?」、2)「この服装はどれくらいカジュアルか?」、3)「この服装をカジュアルにしている要素は何か?」といった問いへの回答を得ることが可能となっていました。

(2) 今回の研究で新たに実現しようとしたこと

一方で、従来のFashion Intelligence System では、全身の服装の画像を一括で学習しており、その中に含まれる個別のアイテム(Tシャツ、パンツ、スカートなど)に関する詳細な質問への回答を得る機能を有していませんでした。

本研究では、Fashion Intelligence Systemの機能を強化し、前述の1)〜3)の質問に加え、4)「この服装の上半身(下半身、靴など)のカジュアル度はどのくらいか」、5)「この服装の上半身をもう少しビジネスカジュアルにするとどんな服装になるか」など、服装に含まれる個別のアイテムに注目した詳細な質問への回答も可能にしようと試みました。これらの問いに対する回答を自動的に獲得することで、ユーザーの認識の幅を広げ、ファッション(服装・着こなし)の解釈や興味喚起のための一助となることを目指しています。

(3)新たに開発した技術

全身の服装を写した画像に関しては、

1. 全身の服装は、複数の個別アイテムから構成される集合として考えることができる。また、(シャツ・パンツ・シューズなどの)必要最低限のアイテムが必ず含まれる。

2. 集合を構成する各アイテムは、調和性を満たす関係にある。(一連のアイテムの相性が良く、組み合わせることで1つの服装として成立する。)

3. 服装Aに含まれるシャツは同一部位(上半身)に着用する他のアイテム(シャツ・パーカーなど)に置換可能であるが、他部位(頭部・下半身など)に着用する他のアイテム(帽子・スニーカーなど)に置き換えることは不可能。

4. 被写体人物のポーズは多様であり、必ずしも画像の特定の部分に固定アイテムが写されているわけではない。

といった個別アイテムに関する特徴があると考えられます。

従来のFashion Intelligence System でベースとしていた技術では、これらの特徴を深く考慮せず、全身の服装の特徴をひとまとめにする形で学習していました。一方で、本研究ではこれらの特徴に対応した上で、全身の服装の画像と当該画像に付与された複数のタグ情報を同一の空間に写像する Partial Visual-Semantic Embedding という新たな機械学習モデルを提案しました。このモデルにより、全身で写った1枚の服装画像から各アイテムに対応する特徴量を個別に抽出した上で、指定したアイテムに対応する特徴量同士の演算が可能になります。

このモデルによって学習された空間における画像とタグの座標(埋め込み表現)を活用することで、前述の1)〜3)のような、コーディネート全体に関する問いにより正確に回答できるようになるだけでなく、4)~5)のような個別アイテムに関する曖昧な問いに対する回答を獲得することができるようになります。

(4) 研究の波及効果や社会的影響

本研究の成果により、Fashion Intelligence Systemが回答可能な質問の範囲が広がり、ユーザーのより詳細な質問に回答することが可能になります。これにより、ファッション特有の曖昧性を軽減し、ファッションに関するユーザーのあらゆる(着る服や購入するアイテムなどの)選択・行動を支援することが期待されます。

(5) 今後の課題

現在のFashion Intelligence Systemから得られる回答(服装画像)は、データセットに含まれる服装画像のみです。つまり、Fashion Intelligence Systemの提供者が用意した服装画像の中から、提示する画像を選択するしくみとなっています。よって、実際のサービスと連携を図りデータを増やすなどの方法で、より正確な服装を提案するようなシステムに拡張していくことなどが今後の課題です。

(6) 研究者のコメント

以前我々が提案したFashion Intelligence Systemを実用可能なシステムにすべく、少しずつ研究を進めています。この提案システムにより、ファッションに苦手意識を持たれている方々が、少しでも快適に過ごせるような世の中を実現できるよう、今後も研究を続けてまいります。

(7) 用語解説

※1 Fashion Intelligence System

本研究グループが開発した、ファッションを自動的に解釈し、ユーザーと協働することで、ファッションに関する新しい知識の発見と新しい価値の創造を促進する仕組みです(https://doi.org/10.1016/j.eswa.2022.119167)。人々の好みや価値観、文化的背景によって評価やイメージが異なる「ファッション」を対象とした、新しい知識の生成と発見を想定しています。

本技術では、全身の服装の画像と当該画像に付与された複数のタグ(ファッション特有の曖昧な表現が含まれた文字情報)の集合を同一ベクトル空間に写像させ、ベクトル空間における画像とタグの座標を活用することで機械学習を行っています。

(8) 研究助成情報

研究費名:日本学術振興会(JSPS)科学研究費 (基盤研究A)

研究課題名:データ駆動型社会の基盤をなす次世代実験計画技術の開発と実証的評価

研究代表者名(所属機関名):後藤 正幸(早稲田大学、 理工学術院)

(9) 論文情報

雑誌名:Knowledge-Based Systems

論文名:Partial visual-semantic embedding: Fine-grained outfit image representation with massive volumes of tags via angular-based contrastive learning

執筆者名(所属機関名):Ryotaro Shimizu (Waseda University and ZOZO Research)、Takuma Nakamura (ZOZO Research)、Masayuki Goto (Waseda University)

掲載日(現地時間):2023年7月28日

掲載URL:https://www.sciencedirect.com/science/article/pii/S0950705123005415

DOI:10.1016/j.knosys.2023.110791